Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

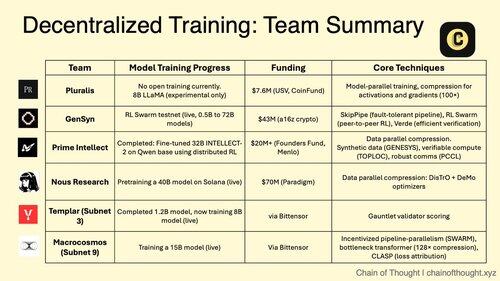

1. Децентралізоване навчання штучного інтелекту переходить від неможливого до неминучого.

Ера централізованих монополій на штучний інтелект кидає виклик проривним протоколам, які дозволяють навчати спільним моделям у розподілених мережах.

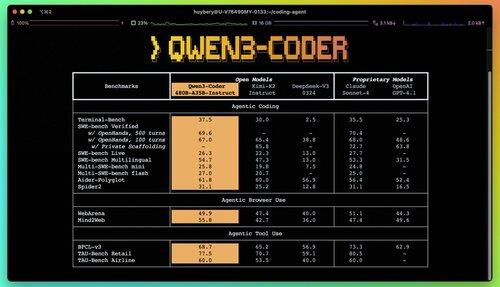

2/ Primer Alert: Qwen 3 Coder щойно випав, і це змінює правила гри.

Нова модель MoE з 480B параметрами та активними параметрами 35B досягає найсучаснішої продуктивності в завданнях агентного кодування, конкуруючи з Claude Sonnet 4.

Цей повністю відкритий кодер підтримує 256K контекст за замовчуванням і 1M з екстраполяцією.

3. Pluralis є піонером «Protocol Learning», радикального підходу, коли моделі навчаються спільно, але ніколи повністю не матеріалізуються в якомусь одному місці.

Початковий раунд у розмірі $7,6 млн від USV та CoinFund підтримує їхнє бачення справді відкритого штучного інтелекту, де учасники діляться економічними перевагами, не відмовляючись від контролю над моделлю.

@PluralisHQ 4/ Nous Research зібрала 50 мільйонів доларів, щоб кинути виклик OpenAI за допомогою моделей, керованих спільнотою.

Їхня майбутня модель «Consilience» з параметром 40B використовує фреймворк Psyche зі стисненням, натхненним JPEG, щоб забезпечити ефективне розподілене навчання на різнорідному обладнанні.

На сьогоднішній день Gensyn залучив ~51 мільйон доларів для створення «глобального кластера машинного навчання».

Їхній протокол об'єднує недостатньо використовувані обчислення по всьому світу, від центрів обробки даних до ігрових ноутбуків, створюючи децентралізовану хмарну альтернативу, яка може досягти юніт-економіки, що перевершує централізованих провайдерів.

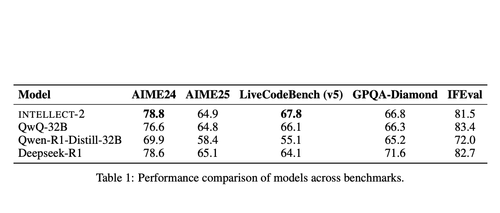

@gensynai 6/ Prime Intellect довів, що децентралізоване навчання працює з ІНТЕЛЕКТ-2.

Їхня модель 32B параметрів була навчена за допомогою глобально розподіленого RL з використанням фреймворку PRIME-RL, демонструючи, що моделі frontier можна створювати на різних континентах без шкоди для продуктивності.

@PrimeIntellect 7/ Підмережі Bittensor спеціалізуються на робочих навантаженнях штучного інтелекту:

- Підмережа 3 (Templar) фокусується на розподіленій перевірці навчання.

- Підмережа 9 (Макрокосмос) дозволяє розробляти спільну модель, створюючи економічні стимули для учасників нейронної мережі.

8/ Теза децентралізованого навчання: агрегувати більше обчислень, ніж будь-яка окрема організація, демократизувати доступ до розробки штучного інтелекту та запобігти концентрації влади.

Оскільки моделі міркувань призводять до вищих витрат на висновки, ніж навчання, розподілені мережі можуть стати важливою інфраструктурою в економіці штучного інтелекту.

8,11K

Найкращі

Рейтинг

Вибране