熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

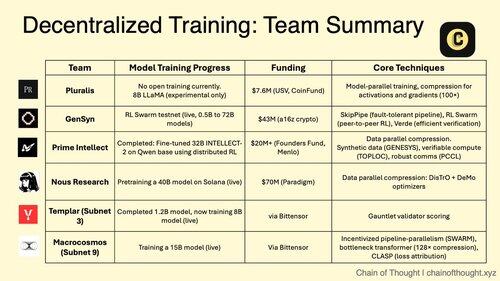

1/ 去中心化的人工智慧訓練正從不可能轉變為不可避免。

集中式人工智慧壟斷的時代正受到突破性協議的挑戰,這些協議使得在分散式網絡中進行協作模型訓練成為可能。

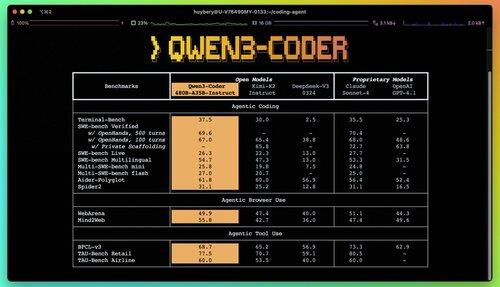

2/ 提醒:Qwen 3 Coder 剛剛發布,這是一個遊戲改變者。

這個擁有 480B 參數的 MoE 模型,具有 35B 活躍參數,在代理編碼任務中達到了最先進的性能,與 Claude Sonnet 4 不相上下。

這個完全開源的編碼器原生支持 256K 上下文,並且在外推時可達 1M。

3/ Pluralis 正在開創 "協議學習",這是一種激進的方法,模型以協作的方式進行訓練,但從未在任何單一位置完全實現。

來自 USV 和 CoinFund 的 760 萬美元種子輪資金支持他們對真正開放 AI 的願景,讓貢獻者在不放棄模型控制權的情況下分享經濟收益。

@PluralisHQ 4/ Nous Research 籌集了 5000 萬美元,以挑戰 OpenAI,推出社群治理的模型。

他們即將推出的 400 億參數 "Consilience" 模型使用 Psyche 框架,並採用 JPEG 啟發的壓縮技術,以實現跨異構硬體的高效分散式訓練。

5/ Gensyn 至今已獲得約 5100 萬美元的資金,以建立「全球機器學習集群」。

他們的協議連接了全球未充分利用的計算資源,從數據中心到遊戲筆記本電腦,創造了一個去中心化的雲端替代方案,可能實現超越集中式提供商的單位經濟。

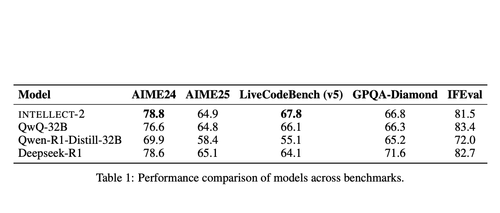

@gensynai 6/ Prime Intellect 證明了去中心化訓練在 INTELLECT-2 上的有效性。

他們的 32B 參數模型通過全球分佈的強化學習 (RL) 使用 PRIME-RL 框架進行訓練,展示了前沿模型可以在不同大陸之間構建,而不會犧牲性能。

@PrimeIntellect 7/ Bittensor 子網專注於 AI 工作負載:

- 子網 3 (Templar) 專注於分散式訓練驗證。

- 子網 9 (Macrocosmos) 使協作模型開發成為可能,為神經網絡中的參與者創造經濟激勵。

8/ 去中心化訓練論文:聚合比任何單一實體更多的計算能力,民主化AI開發的訪問權限,並防止權力集中。

隨著推理模型使推斷成本高於訓練,分佈式網絡可能成為AI經濟中的關鍵基礎設施。

8.11K

熱門

排行

收藏