トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

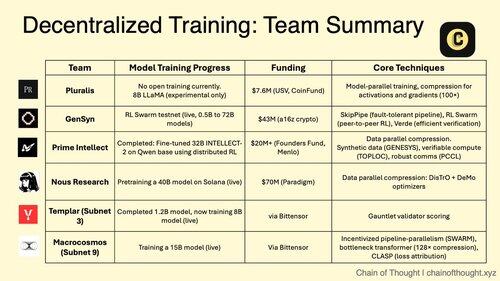

1/ 分散型 AI トレーニングは不可能から避けられないものへと移行しています。

中央集権的な AI 独占の時代は、分散ネットワーク全体での共同モデル トレーニングを可能にする画期的なプロトコルによって挑戦されています。

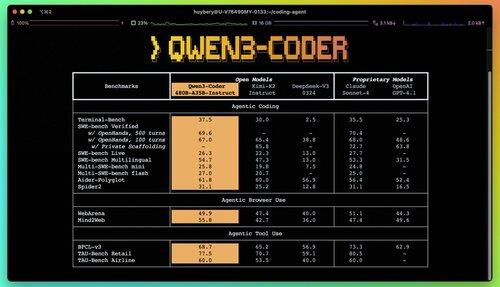

2/ 入門アラート: Qwen 3 Coder がリリースされたばかりで、ゲームチェンジャーです。

35Bのアクティブパラメータを備えた新しい480BパラメータのMoEモデルは、Claude Sonnet 4に匹敵するエージェントコーディングタスクで最先端のパフォーマンスを実現します。

この完全にオープンソースのコーダーは、ネイティブに256Kコンテキストをサポートし、外挿で1Mをサポートします。

3/ Pluralisは、モデルが共同でトレーニングされるが、単一の場所で完全に具体化されることはありませんという根本的なアプローチである「プロトコル学習」の先駆者です。

USV と CoinFund からの $7.6M シードラウンドは、貢献者がモデル制御を放棄することなく経済的上昇余地を共有する、真にオープンな AI というビジョンを裏付けています。

@PluralisHQ 4/ Nous Research は、コミュニティが管理するモデルで OpenAI に挑戦するために $50M を調達しました。

今後の 40B パラメーター「Consilience」モデルは、JPEG にインスパイアされた圧縮を備えた Psyche フレームワークを使用して、異種ハードウェア間での効率的な分散トレーニングを可能にします。

5/ Gensynは、「グローバル機械学習クラスター」を構築するために、これまでに~$51Mを確保しました。

彼らのプロトコルは、データセンターからゲーム用ラップトップに至るまで、世界中で十分に活用されていないコンピューティングを接続し、集中型プロバイダーを超える単位経済性を達成できる分散型クラウドの代替手段を作成します。

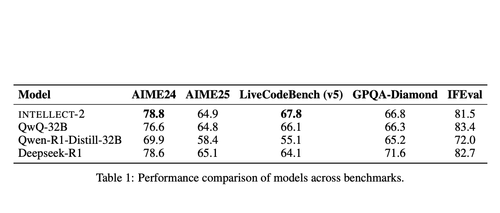

@gensynai 6/ Prime Intellectは、分散型トレーニングがINTELLECT-2で機能することを証明しました。

彼らの 32B パラメーター モデルは、PRIME-RL フレームワークを使用してグローバルに分散された RL を介してトレーニングされ、パフォーマンスを犠牲にすることなく大陸をまたいでフロンティア モデルを構築できることを実証しました。

@PrimeIntellect 7/ Bittensor サブネットは AI ワークロードに特化しています。

- サブネット 3 (Templar) は、分散トレーニングの検証に重点を置いています。

- サブネット 9 (Macrocosmos) は共同モデル開発を可能にし、ニューラル ネットワークの参加者に経済的インセンティブを生み出します。

8/分散型トレーニングのテーゼ: 単一のエンティティよりも多くのコンピューティングを集約し、AI 開発へのアクセスを民主化し、権力の集中を防ぎます。

推論モデルはトレーニングよりも推論コストが高くなるため、分散ネットワークは AI 経済において不可欠なインフラストラクチャになる可能性があります。

8.12K

トップ

ランキング

お気に入り