Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

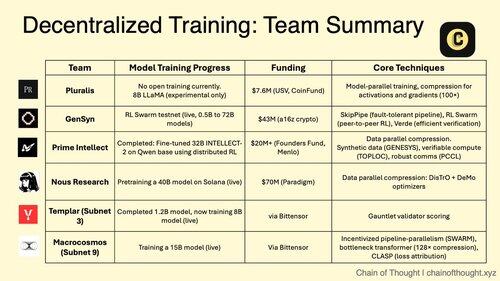

1/ L'addestramento AI decentralizzato sta passando da impossibile a inevitabile.

L'era dei monopoli AI centralizzati è messa in discussione da protocolli innovativi che consentono l'addestramento collaborativo dei modelli attraverso reti distribuite.

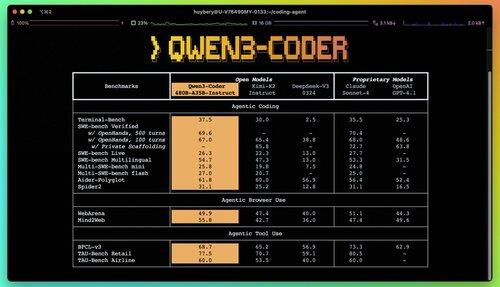

2/ Avviso Primer: Qwen 3 Coder è appena uscito ed è un cambiamento radicale.

Il nuovo modello MoE con 480 miliardi di parametri e 35 miliardi di parametri attivi raggiunge prestazioni all'avanguardia nei compiti di codifica agentica, rivaleggiando con Claude Sonnet 4.

Questo coder completamente open-source supporta nativamente 256K di contesto e 1M con estrapolazione.

3/ Pluralis sta pionierando il "Protocol Learning", un approccio radicale in cui i modelli vengono addestrati in modo collaborativo ma non si materializzano mai completamente in un'unica posizione.

Un round di finanziamento seed di 7,6 milioni di dollari da USV e CoinFund sostiene la loro visione di un'AI veramente aperta in cui i contributori condividono i benefici economici senza rinunciare al controllo del modello.

@PluralisHQ 4/ Nous Research ha raccolto 50 milioni di dollari per sfidare OpenAI con modelli governati dalla comunità.

Il loro prossimo modello "Consilience" da 40 miliardi di parametri utilizza il framework Psyche con compressione ispirata a JPEG per abilitare un addestramento distribuito efficiente su hardware eterogeneo.

5/ Gensyn ha raccolto circa 51 milioni di dollari fino ad oggi per costruire il "cluster globale di machine learning."

Il loro protocollo connette risorse di calcolo sottoutilizzate in tutto il mondo, dai data center ai laptop da gioco, creando un'alternativa cloud decentralizzata che potrebbe raggiungere economie di scala superiori a quelle dei fornitori centralizzati.

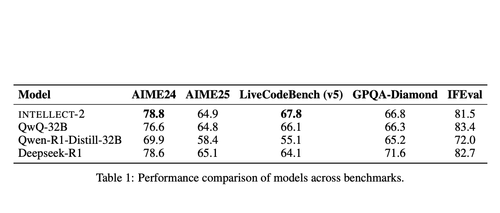

@gensynai 6/ Prime Intellect ha dimostrato che l'addestramento decentralizzato funziona con INTELLECT-2.

Il loro modello da 32 miliardi di parametri è stato addestrato tramite RL distribuito globalmente utilizzando il framework PRIME-RL, dimostrando che i modelli all'avanguardia possono essere costruiti attraverso i continenti senza compromettere le prestazioni.

@PrimeIntellect 7/ I sottoreti di Bittensor si specializzano in carichi di lavoro AI:

- Sottorete 3 (Templar) si concentra sulla validazione dell'addestramento distribuito.

- Sottorete 9 (Macrocosmos) consente lo sviluppo collaborativo di modelli, creando incentivi economici per i partecipanti nella rete neurale.

8/ La tesi del training decentralizzato: aggregare più potenza di calcolo di qualsiasi singola entità, democratizzare l'accesso allo sviluppo dell'IA e prevenire la concentrazione del potere.

Poiché i modelli di ragionamento fanno aumentare i costi di inferenza rispetto al training, le reti distribuite potrebbero diventare un'infrastruttura essenziale nell'economia dell'IA.

8,12K

Principali

Ranking

Preferiti