Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

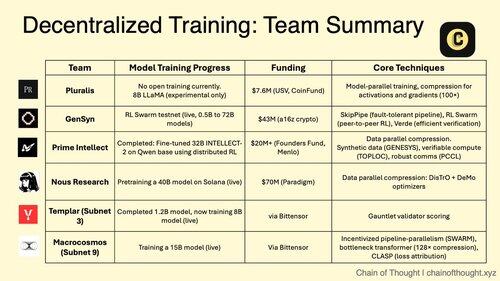

1/ Gedecentraliseerde AI-training verschuift van onmogelijk naar onvermijdelijk.

Het tijdperk van gecentraliseerde AI-monopolies wordt uitgedaagd door baanbrekende protocollen die collaboratieve modeltraining mogelijk maken over gedistribueerde netwerken.

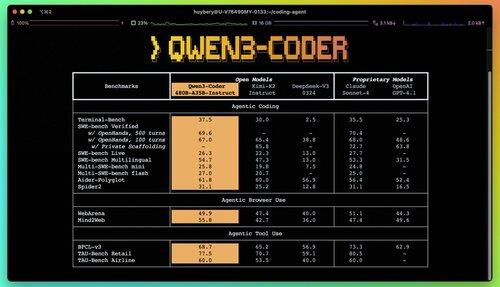

2/ Primer Alert: Qwen 3 Coder is net uitgebracht en het is een game changer.

Het nieuwe 480B-parameter MoE-model met 35B actieve parameters behaalt state-of-the-art prestaties in agentic coding taken, rivaliserend met Claude Sonnet 4.

Deze volledig open-source coder ondersteunt 256K context inheems en 1M met extrapolatie.

3/ Pluralis is pionierend in "Protocol Learning", een radicale benadering waarbij modellen collaboratief worden getraind maar nooit volledig gematerialiseerd zijn op één enkele locatie.

$7,6 miljoen seedronde van USV en CoinFund ondersteunt hun visie van echt open AI waarbij bijdragers economische voordelen delen zonder de controle over het model op te geven.

@PluralisHQ 4/ Nous Research heeft $50 miljoen opgehaald om OpenAI uit te dagen met gemeenschapsgebaseerde modellen.

Hun aankomende 40B parameter "Consilience" model maakt gebruik van het Psyche-framework met JPEG-geïnspireerde compressie om efficiënte gedistribueerde training mogelijk te maken op heterogene hardware.

5/ Gensyn heeft tot nu toe ~$51M veiliggesteld om de "wereldwijde machine learning cluster" te bouwen.

Hun protocol verbindt onderbenutte rekencapaciteit wereldwijd, van datacenters tot gaming laptops, en creëert een gedecentraliseerd cloudalternatief dat unit economics kan bereiken die de gecentraliseerde aanbieders overtreffen.

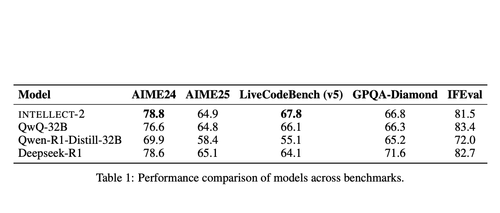

@gensynai 6/ Prime Intellect bewees dat gedecentraliseerde training werkt met INTELLECT-2.

Hun 32B parameter model werd getraind via wereldwijd gedistribueerde RL met behulp van het PRIME-RL framework, wat aantoont dat grensmodellen over continenten kunnen worden gebouwd zonder in te boeten op prestaties.

@PrimeIntellect 7/ Bittensor-subnetten zijn gespecialiseerd in AI-werkbelastingen:

- Subnet 3 (Templar) richt zich op gedistribueerde trainingsvalidatie.

- Subnet 9 (Macrocosmos) maakt samenwerkingsmodelontwikkeling mogelijk en creëert economische prikkels voor deelnemers in het neurale netwerk.

8/ De gedecentraliseerde trainingsthesis: Verzamel meer rekenkracht dan welke enkele entiteit dan ook, democratiseer de toegang tot AI-ontwikkeling en voorkom concentratie van macht.

Naarmate redeneermodellen de kosten voor inferentie hoger maken dan die voor training, kunnen gedistribueerde netwerken essentiële infrastructuur worden in de AI-economie.

8,25K

Boven

Positie

Favorieten