Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

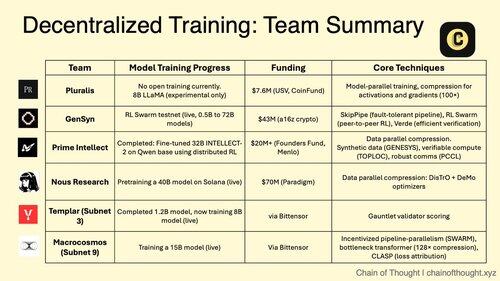

1/ El entrenamiento descentralizado de IA está pasando de imposible a inevitable.

La era de los monopolios centralizados de IA está siendo desafiada por protocolos innovadores que permiten el entrenamiento de modelos colaborativos en redes distribuidas.

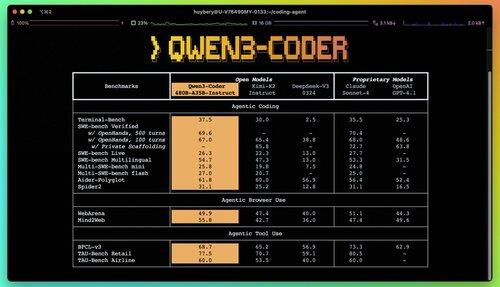

2/ Alerta de cebador: Qwen 3 Coder acaba de lanzarse y es un cambio de juego.

El nuevo modelo MoE de 480 B parámetros con 35 B de parámetros activos logra un rendimiento de vanguardia en tareas de codificación agencial, rivalizando con Claude Sonnet 4.

Este codificador de código abierto totalmente admite 256K de contexto de forma nativa y 1M con extrapolación.

3/ Pluralis es pionera en el "Aprendizaje de protocolos", un enfoque radical en el que los modelos se entrenan en colaboración pero nunca se materializan completamente en un solo lugar.

La ronda inicial de 7,6 millones de dólares de USV y CoinFund respalda su visión de una IA verdaderamente abierta en la que los contribuyentes comparten las ventajas económicas sin ceder el control del modelo.

@PluralisHQ 4/ Nous Research recaudó 50 millones de dólares para desafiar a OpenAI con modelos gobernados por la comunidad.

Su próximo modelo de "Consiliencia" de parámetros 40B utiliza el marco Psyche con compresión inspirada en JPEG para permitir un entrenamiento distribuido eficiente en hardware heterogéneo.

5/ Gensyn ha asegurado ~ $ 51 millones hasta la fecha para construir el "clúster global de aprendizaje automático".

Su protocolo conecta la computación infrautilizada en todo el mundo, desde centros de datos hasta computadoras portátiles para juegos, creando una alternativa de nube descentralizada que podría lograr una economía unitaria que supere a los proveedores centralizados.

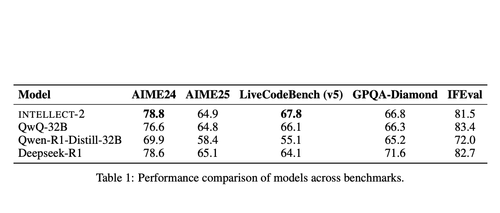

@gensynai 6/ Prime Intellect demostró que el entrenamiento descentralizado funciona con INTELLECT-2.

Su modelo de parámetros 32B se entrenó a través de RL distribuido globalmente utilizando el marco PRIME-RL, lo que demuestra que los modelos de frontera se pueden construir en todos los continentes sin sacrificar el rendimiento.

@PrimeIntellect 7/ Las subredes de Bittensor se especializan en cargas de trabajo de IA:

- Subred 3 (Templar) se centra en la validación de entrenamiento distribuido.

- La subred 9 (Macrocosmos) permite el desarrollo de modelos colaborativos, creando incentivos económicos para los participantes en la red neuronal.

8/ La tesis de entrenamiento descentralizado: agregar más computación que cualquier entidad individual, democratizar el acceso al desarrollo de IA y evitar la concentración de poder.

A medida que los modelos de razonamiento aumentan los costos de inferencia que el entrenamiento, las redes distribuidas pueden convertirse en una infraestructura esencial en la economía de la IA.

8.11K

Populares

Ranking

Favoritas