المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

SWE-bench Verified هو المعيار الذهبي لتقييم وكلاء الترميز: 500 مشكلة في العالم الحقيقي + اختبارات بواسطة OpenAI. يبدو مضادا للرصاص؟ ليس تمامًا.

نظهر اجتياز اختبارات الوحدة != مطابقة الحقيقة الأرضية. في ورقة ACL الخاصة بنا ، قمنا بإصلاح إيفالات عربات التي تجرها الدواب: تحرك 24٪ من الوكلاء لأعلى أو لأسفل لوحة المتصدرين!

1/7

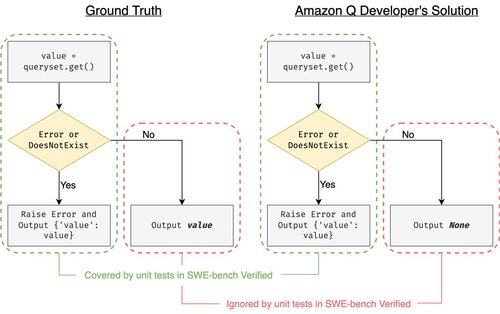

مثال: django PR-13933. قام العامل بإصلاح رسالة خطأ ولكنه كسر التنفيذ العادي بصمت. جميع الاختبارات خضراء ، في حين أن التصحيح سيتعطل في الإنتاج.

3/7

لمعالجة حالات الاختبار غير الكافية في SWE-bench ، قمنا بتطوير UTBoost ، وهو منشئ حالة اختبار قائم على LLM لمشاريع Python واسعة النطاق. تحت الغطاء ، يقوم UTboost أولا بترجمة التعليمات البرمجية ذات الصلة بطريقة دقيقة (مستوى الملف -> مستوى الوظيفة -> مستوى السطر) ، ثم يقوم تلقائيا بإنشاء اختبارات نمط pytest.

4/7

بالنظر إلى حالات الاختبار التي تم إنشاؤها ، تحققنا من صحتها وأعدنا تقييم الوكلاء في لوحات المتصدرين الحالية ل SWE-bench Lite وتم التحقق منها:

- SWE-bench Lite: + 28.4٪ أكثر من البقع الخاطئة التي تم اكتشافها

- تم التحقق من مقاعد البدلاء السويدية: + 15.7٪

- تم تغيير التصنيفات بنسبة 40.9٪ (Lite) و 24.4٪ (تم التحقق منه)

5/7

الدرس: يكون الاختبار صعبا وأصعب عندما يكتب الذكاء الاصطناعي الكود. يجب أن تتطور المعايير مع أجنحة أقوى ومتنامية باستمرار. نأمل أن يكون UTBoost خطوة واحدة نحو إيفال أكثر موثوقية.

6/7

هذا عمل مشترك مع @BoshCavendish و @maxYuxuanZhu و @PinjiaHE

7/7

24.88K

الأفضل

المُتصدِّرة

التطبيقات المفضلة