Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

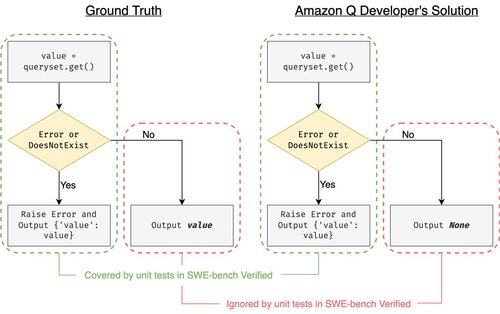

SWE-bench Verified este standardul de aur pentru evaluarea agenților de codare: 500 de probleme din lumea reală + teste de OpenAI. Sună rezistent la glonț? Aproape.

Arătăm că trecerea testelor sale unitare != se potrivește cu adevărul de bază. În lucrarea noastră ACL, am corectat evaluările cu erori: 24% dintre agenți au urcat sau au coborât în clasament!

1/7

Exemplu: django PR-13933. Agentul a remediat un mesaj de eroare, dar a întrerupt în tăcere execuția normală. Toate testele sunt verzi, în timp ce patch-ul s-ar prăbuși în producție.

3/7

Pentru a rezolva cazurile de testare insuficiente din SWE-bench, am dezvoltat UTBoost, un generator de cazuri de testare bazat pe LLM pentru proiecte Python la scară largă. Sub capotă, UTboost localizează mai întâi codul relevant într-un mod fin (nivel de fișier -> nivel de funcție -> nivel de linie) și apoi generează automat teste în stil pytest.

4/7

Având în vedere cazurile de testare generate, am verificat corectitudinea acestora și am reevaluat agenții din clasamentele actuale ale SWE-bench Lite și Verificat:

- SWE-bench Lite: +28,4% mai multe patch-uri greșite prinse

- SWE-bench verificat: +15,7%

- Ranguri modificate 40,9 % (Lite) și 24,4 % (Verificat)

5/7

Lecție: Testarea este dificilă și chiar mai dificilă atunci când AI scrie codul. Benchmark-urile trebuie să evolueze cu suite mai puternice, în continuă creștere. Sperăm că UTBoost este un pas către evaluări mai fiabile.

6/7

Aceasta este o muncă comună cu @BoshCavendish, @maxYuxuanZhu și @PinjiaHE

7/7

24,87K

Limită superioară

Clasament

Favorite