Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

SWE-bench Verified — это золотой стандарт для оценки кодирующих агентов: 500 реальных задач + тесты от OpenAI. Звучит надежно? Не совсем.

Мы показываем, что прохождение его юнит-тестов != соответствие реальности. В нашей статье ACL мы исправили ошибочные оценки: 24% агентов поднялись или опустились в таблице лидеров!

1/7

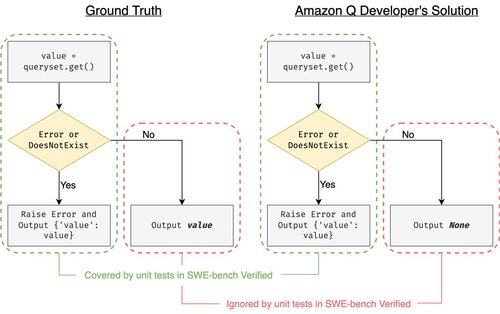

Пример: django PR-13933. Агент исправил сообщение об ошибке, но тихо сломал нормальное выполнение. Все тесты проходят, в то время как патч приведет к сбою в производственной среде.

3/7

Чтобы решить проблему недостаточного количества тестовых случаев в SWE-bench, мы разработали UTBoost, генератор тестовых случаев на основе LLM для полнофункциональных проектов на Python. Внутри UTBoost сначала локализует соответствующий код на детальном уровне (уровень файла -> уровень функции -> уровень строки), а затем автоматически генерирует тесты в стиле pytest.

4/7

Учитывая сгенерированные тестовые случаи, мы проверили их правильность и переоценили агентов на текущих таблицах лидеров SWE-bench Lite и Verified:

- SWE-bench Lite: на 28.4% больше неправильных патчей поймано

- SWE-bench Verified: на 15.7%

- Ранги изменились на 40.9% (Lite) и 24.4% (Verified)

5/7

Урок: Тестирование сложно, а еще сложнее, когда код пишет ИИ. Бенчмарки должны развиваться с более мощными, постоянно растущими наборами. Мы надеемся, что UTBoost — это шаг к более надежным оценкам.

6/7

Это совместная работа с @BoshCavendish, @maxYuxuanZhu и @PinjiaHE

7/7

24,88K

Топ

Рейтинг

Избранное