Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

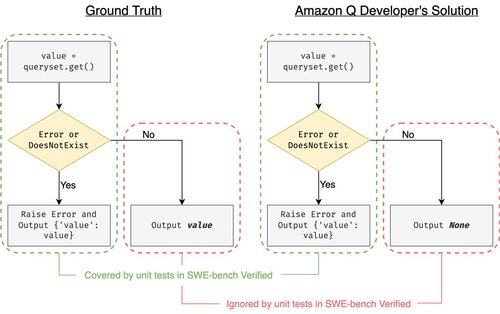

SWE-bench Verified là tiêu chuẩn vàng để đánh giá các tác nhân lập trình: 500 vấn đề thực tế + bài kiểm tra của OpenAI. Nghe có vẻ không thể sai? Không hẳn.

Chúng tôi cho thấy việc vượt qua các bài kiểm tra đơn vị không đồng nghĩa với việc khớp với sự thật. Trong bài báo ACL của chúng tôi, chúng tôi đã sửa các đánh giá lỗi: 24% các tác nhân đã di chuyển lên hoặc xuống bảng xếp hạng!

1/7

Ví dụ: django PR-13933. Đại lý đã sửa một thông báo lỗi nhưng đã âm thầm làm hỏng quá trình thực thi bình thường. Tất cả các bài kiểm tra đều thành công, trong khi bản vá sẽ gây ra sự cố trong môi trường sản xuất.

3/7

Để giải quyết vấn đề thiếu hụt các trường hợp kiểm tra trong SWE-bench, chúng tôi đã phát triển UTBoost, một trình tạo trường hợp kiểm tra dựa trên LLM cho các dự án Python quy mô lớn. Ở bên trong, UTBoost trước tiên định vị mã liên quan một cách chi tiết (mức tệp -> mức hàm -> mức dòng), và sau đó tự động tạo ra các bài kiểm tra theo phong cách pytest.

4/7

Dựa trên các trường hợp thử nghiệm đã được tạo ra, chúng tôi đã xác minh tính chính xác của chúng và đánh giá lại các tác nhân trên bảng xếp hạng hiện tại của SWE-bench Lite và Verified:

- SWE-bench Lite: +28.4% số bản vá sai bị phát hiện

- SWE-bench Verified: +15.7%

- Thứ hạng thay đổi 40.9% (Lite) & 24.4% (Verified)

5/7

Bài học: Kiểm tra là khó và còn khó hơn khi AI viết mã. Các tiêu chuẩn phải phát triển với những bộ kiểm tra mạnh mẽ hơn, ngày càng lớn hơn. Chúng tôi hy vọng UTBoost là một bước tiến tới những đánh giá đáng tin cậy hơn.

6/7

Đây là công việc chung với @BoshCavendish, @maxYuxuanZhu, và @PinjiaHE

7/7

24,87K

Hàng đầu

Thứ hạng

Yêu thích