热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

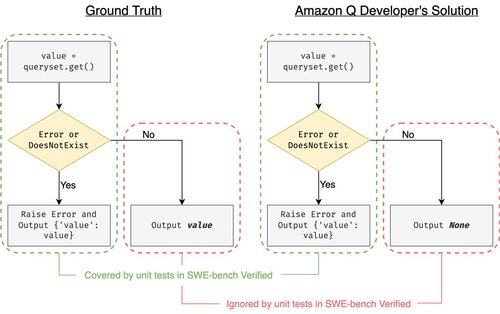

SWE-bench Verified 是评估编码代理的黄金标准:500 个真实世界问题 + OpenAI 的测试。听起来无懈可击?其实并非如此。

我们展示了通过单元测试并不等于与真实结果相匹配。在我们的 ACL 论文中,我们修复了有缺陷的评估:24% 的代理在排行榜上上升或下降了!

1/7

示例:django PR-13933。代理修复了一个错误消息,但默默地破坏了正常执行。所有测试都通过了,而补丁在生产环境中会崩溃。

3/7

为了应对SWE-bench中测试用例不足的问题,我们开发了UTBoost,这是一种基于LLM的全规模Python项目测试用例生成器。在内部,UTBoost首先以细粒度的方式定位相关代码(文件级 -> 函数级 -> 行级),然后自动生成pytest风格的测试。

4/7

根据生成的测试用例,我们验证了它们的正确性,并在当前的SWE-bench Lite和Verified排行榜上重新评估了代理:

- SWE-bench Lite:捕获的错误补丁增加了28.4%

- SWE-bench Verified:增加了15.7%

- 排名变化40.9%(Lite)和24.4%(Verified)

5/7

课程:测试很困难,当 AI 编写代码时更是如此。基准测试必须随着更强大、不断增长的套件而发展。我们希望 UTBoost 是朝着更可靠评估迈出的一步。

6/7

这是与 @BoshCavendish, @maxYuxuanZhu 和 @PinjiaHE 的合作

7/7

24.84K

热门

排行

收藏