トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

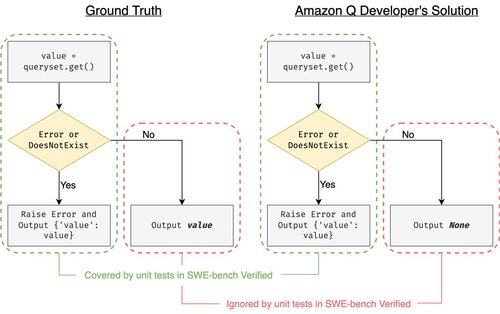

SWE-bench Verified は、コーディング エージェントを評価するためのゴールド スタンダードです: 500 の現実世界の問題 + OpenAI によるテスト。防弾のように聞こえますか?まだまだです。

単体テストに合格することを示します != グラウンドトゥルースに一致します。ACLの論文では、エージェントの24%がリーダーボードを上下に上げたというバグのある評価を修正しました。

1/7

例: ジャンゴ PR-13933。エージェントはエラーメッセージを修正しましたが、通常の実行を静かに中断しました。すべてのテストは緑色ですが、パッチは本番環境でクラッシュします。

3/7

SWE-benchの不十分なテストケースに対処するために、本格的なPythonプロジェクト向けのLLMベースのテストケースジェネレーターであるUTBoostを開発しました。内部的には、UTboost はまず関連するコードをきめ細かい方法でローカライズし (ファイル レベル -> 関数レベル ->行レベル)、次に pytest スタイルのテストを自動的に生成します。

4/7

生成されたテストケースを考慮して、その正確性を検証し、SWE-bench Liteの現在のリーダーボードでエージェントを再評価し、検証しました。

- SWE-bench Lite: +28.4% の誤ったパッチが検出されました

- SWE-bench検証済み:+15.7%

- ランク変更: 40.9 % (Lite) & 24.4 % (検証済み)

5/7

教訓: テストは難しく、AI がコードを書く場合、さらに困難です。ベンチマークは、より強力で成長し続けるスイートとともに進化する必要があります。UTBoostが、より信頼性の高い評価への一歩となることを願っています。

6/7

これは、@BoshCavendish、@maxYuxuanZhu、@PinjiaHEとの共同作業です

7/7

24.84K

トップ

ランキング

お気に入り