Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

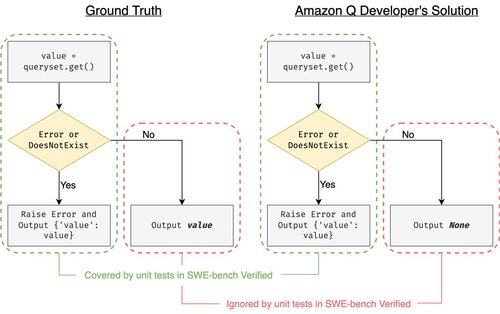

SWE-bench Verified to złoty standard oceny agentów kodujących: 500 rzeczywistych problemów + testy od OpenAI. Brzmi niezawodnie? Nie do końca.

Pokazujemy, że przejście testów jednostkowych != dopasowanie do prawdy. W naszym artykule ACL naprawiliśmy błędne oceny: 24% agentów przesunęło się w górę lub w dół na liście rankingowej!

1/7

Przykład: django PR-13933. Agent naprawił komunikat o błędzie, ale cicho zepsuł normalne wykonanie. Wszystkie testy są zielone, podczas gdy poprawka spowodowałaby awarię w produkcji.

3/7

Aby rozwiązać problem niewystarczającej liczby przypadków testowych w SWE-bench, opracowaliśmy UTBoost, generator przypadków testowych oparty na LLM dla pełnoskalowych projektów w Pythonie. W tle UTBoost najpierw lokalizuje odpowiedni kod w sposób szczegółowy (poziom pliku -> poziom funkcji -> poziom linii), a następnie automatycznie generuje testy w stylu pytest.

4/7

Biorąc pod uwagę wygenerowane przypadki testowe, zweryfikowaliśmy ich poprawność i ponownie oceniliśmy agentów na aktualnych rankingach SWE-bench Lite i Verified:

- SWE-bench Lite: +28,4% więcej złych poprawek wykrytych

- SWE-bench Verified: +15,7%

- Zmiany w rankingach 40,9% (Lite) i 24,4% (Verified)

5/7

Lekcja: Testowanie jest trudne, a jeszcze trudniejsze, gdy kod pisze AI. Benchmarki muszą ewoluować wraz z coraz silniejszymi, rosnącymi zestawami. Mamy nadzieję, że UTBoost to krok w stronę bardziej wiarygodnych ocen.

6/7

To jest wspólna praca z @BoshCavendish, @maxYuxuanZhu i @PinjiaHE

7/7

24,86K

Najlepsze

Ranking

Ulubione