Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

SWE-bench Verified es el estándar de oro para evaluar agentes de codificación: 500 problemas del mundo real + pruebas de OpenAI. ¿Suena a prueba de balas? Casi.

Mostramos pasar sus pruebas unitarias != coincidiendo con la verdad fundamental. En nuestro documento de ACL, corrigimos evaluaciones con errores: ¡el 24% de los agentes subieron o bajaron en la tabla de clasificación!

1/7

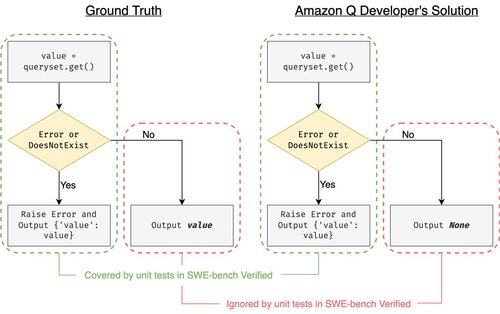

Ejemplo: django PR-13933. El agente corrigió un mensaje de error, pero interrumpió silenciosamente la ejecución normal. Todas las pruebas son verdes, mientras que el parche se bloquearía en producción.

3/7

Para abordar los casos de prueba insuficientes en SWE-bench, desarrollamos UTBoost, un generador de casos de prueba basado en LLM para proyectos de Python a gran escala. Bajo el capó, UTboost primero localiza el código relevante de una manera detallada (nivel de archivo -> nivel de función -> nivel de línea) y luego genera automáticamente pruebas de estilo pytest.

4/7

Dados los casos de prueba generados, verificamos su corrección y reevaluamos los agentes en las tablas de clasificación actuales de SWE-bench Lite y Verified:

- SWE-bench Lite: +28,4% más de parches erróneos detectados

- SWE-bench verificado: +15.7%

- Los rangos cambiaron 40.9 % (Lite) y 24.4 % (Verificado)

5/7

Lección: Las pruebas son difíciles y aún más difíciles cuando la IA escribe el código. Los puntos de referencia deben evolucionar con suites más sólidas y en constante crecimiento. Esperamos que UTBoost sea un paso hacia evaluaciones más confiables.

6/7

Este es un trabajo conjunto con @BoshCavendish, @maxYuxuanZhu y @PinjiaHE

7/7

24.87K

Populares

Ranking

Favoritas