Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

SWE-bench Verified is de gouden standaard voor het evalueren van coderingsagenten: 500 echte wereldproblemen + tests van OpenAI. Klinkt waterdicht? Niet helemaal.

We tonen aan dat het slagen voor de eenheidstests != overeenkomen met de grondwaarheid. In ons ACL-papier hebben we foutieve evaluaties gecorrigeerd: 24% van de agenten steeg of daalde op de ranglijst!

1/7

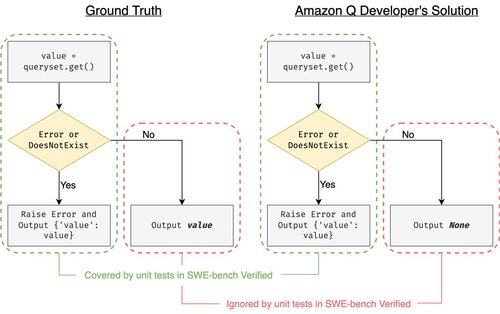

Voorbeeld: django PR-13933. De agent heeft een foutmelding verholpen, maar heeft stilletjes de normale uitvoering verbroken. Alle tests zijn groen, terwijl de patch in productie zou crashen.

3/7

Om de onvoldoende testgevallen in SWE-bench aan te pakken, hebben we UTBoost ontwikkeld, een LLM-gebaseerde testgevalgenerator voor grootschalige Python-projecten. Onder de motorkap lokaliseert UTBoost eerst relevante code op een fijnmazige manier (bestandsniveau -> functieniveau -> regelniveau) en genereert vervolgens automatisch pytest-stijl tests.

4/7

Gegeven de gegenereerde testgevallen hebben we hun correctheid geverifieerd en de agents opnieuw geëvalueerd op de huidige ranglijsten van SWE-bench Lite en Verified:

- SWE-bench Lite: +28,4% meer foute patches gevangen

- SWE-bench Verified: +15,7%

- Rangen veranderd 40,9% (Lite) & 24,4% (Verified)

5/7

Les: Testen is moeilijk en nog moeilijker wanneer AI de code schrijft. Benchmarks moeten evolueren met sterkere, steeds groeiende suites. We hopen dat UTBoost een stap is naar betrouwbaardere evaluaties.

6/7

Dit is gezamenlijk werk met @BoshCavendish, @maxYuxuanZhu, en @PinjiaHE

7/7

24,89K

Boven

Positie

Favorieten