Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

SWE-bench Verified – це золотий стандарт оцінки кодуючих агентів: 500 реальних проблем + тести від OpenAI. Звучить куленепробивно? Не зовсім.

Ми показуємо проходження його одиничних тестів != відповідну правду. У нашому документі ACL ми виправили помилки: 24% агентів перемістилися вгору або вниз по таблиці лідерів!

1/7

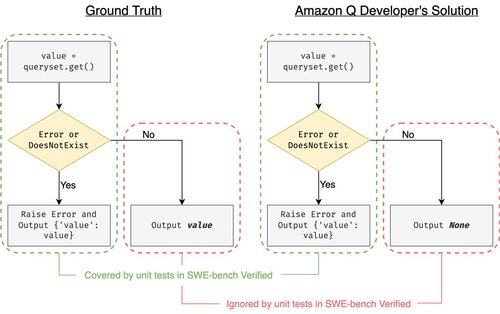

Приклад: django PR-13933. Агент виправив повідомлення про помилку, але мовчки порушив нормальне виконання. Усі тести зеленого кольору, тоді як патч зазнає збою у виробництві.

3/7

Щоб вирішити проблему недостатньої кількості тест-кейсів у SWE-bench, ми розробили UTBoost — генератор тестових випадків на основі LLM для повномасштабних проєктів на Python. Під капотом UTboost спочатку локалізує відповідний код у тонкий спосіб (рівень файлу -> рівень функції -> рівень рядка), а потім автоматично генерує тести в стилі pytest.

4/7

З огляду на згенеровані тест-кейси, ми перевірили їх коректність і повторно оцінили агентів в поточних лідербордах SWE-bench Lite і Verified:

- SWE-bench Lite: на +28,4% більше виявлено неправильних патчів

- Підтверджено SWE-bench: +15.7%

- Зміни в рейтингах: 40.9 % (Lite) & 24.4 % (Перевірено)

5/7

Урок: Тестування стає важким і навіть важчим, коли ШІ пише код. Орієнтири повинні розвиватися разом із сильнішими, постійно зростаючими наборами. Ми сподіваємося, що UTBoost стане одним із кроків до більш надійних евалів.

6/7

Це спільна робота з @BoshCavendish, @maxYuxuanZhu та @PinjiaHE

7/7

24,85K

Найкращі

Рейтинг

Вибране