Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

SWE-bench Verified ist der Goldstandard zur Bewertung von Codierungsagenten: 500 reale Probleme + Tests von OpenAI. Klingt wasserdicht? Nicht ganz.

Wir zeigen, dass das Bestehen seiner Unit-Tests != Übereinstimmung mit der Grundwahrheit ist. In unserem ACL-Papier haben wir fehlerhafte Bewertungen behoben: 24% der Agenten sind in der Rangliste aufgestiegen oder gefallen!

1/7

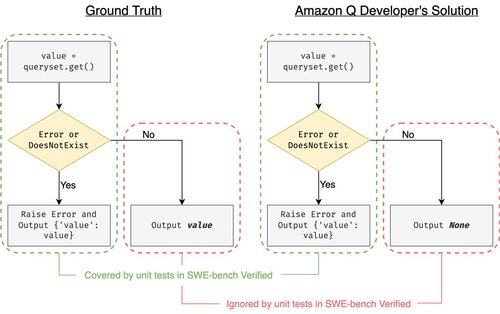

Beispiel: django PR-13933. Der Agent hat eine Fehlermeldung behoben, aber die normale Ausführung stillschweigend unterbrochen. Alle Tests sind grün, während der Patch in der Produktion abstürzen würde.

3/7

Um die unzureichenden Testfälle in SWE-bench zu beheben, haben wir UTBoost entwickelt, einen LLM-basierten Testfallgenerator für umfassende Python-Projekte. Im Hintergrund lokalisiert UTBoost zunächst relevante Codes auf feingranularer Ebene (Dateiebene -> Funktionsebene -> Zeilenebene) und generiert dann automatisch Tests im pytest-Stil.

4/7

Angesichts der generierten Testfälle haben wir deren Richtigkeit überprüft und die Agenten auf den aktuellen Bestenlisten von SWE-bench Lite und Verified neu bewertet:

- SWE-bench Lite: +28,4 % mehr falsch gefangene Patches

- SWE-bench Verified: +15,7 %

- Ränge änderten sich um 40,9 % (Lite) & 24,4 % (Verified)

5/7

Lektion: Testen ist schwierig und noch schwieriger, wenn KI den Code schreibt. Benchmarks müssen sich mit stärkeren, ständig wachsenden Suiten weiterentwickeln. Wir hoffen, dass UTBoost ein Schritt in Richtung zuverlässigerer Bewertungen ist.

6/7

Dies ist eine gemeinsame Arbeit mit @BoshCavendish, @maxYuxuanZhu und @PinjiaHE

7/7

24,86K

Top

Ranking

Favoriten