Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

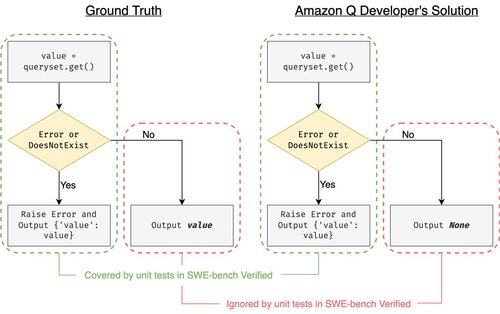

SWE-bench Verified est la référence en matière d'évaluation des agents de codage : 500 problèmes réels + tests par OpenAI. Ça semble infaillible ? Pas tout à fait.

Nous montrons que passer ses tests unitaires != correspondre à la vérité de terrain. Dans notre article ACL, nous avons corrigé des évaluations défectueuses : 24 % des agents ont changé de position dans le classement !

1/7

Exemple : django PR-13933. L'agent a corrigé un message d'erreur mais a silencieusement rompu l'exécution normale. Tous les tests sont réussis, tandis que le correctif provoquerait un crash en production.

3/7

Pour remédier au nombre insuffisant de cas de test dans SWE-bench, nous avons développé UTBoost, un générateur de cas de test basé sur LLM pour des projets Python à grande échelle. En coulisses, UTBoost localise d'abord le code pertinent de manière fine (niveau de fichier -> niveau de fonction -> niveau de ligne), puis génère automatiquement des tests au format pytest.

4/7

Étant donné les cas de test générés, nous avons vérifié leur exactitude et réévalué les agents sur les classements actuels de SWE-bench Lite et Verified :

- SWE-bench Lite : +28,4 % de patchs erronés détectés

- SWE-bench Verified : +15,7 %

- Les classements ont changé de 40,9 % (Lite) et 24,4 % (Verified)

5/7

Leçon : Tester est difficile et encore plus difficile lorsque l'IA écrit le code. Les benchmarks doivent évoluer avec des suites de tests de plus en plus robustes. Nous espérons qu'UTBoost est un pas vers des évaluations plus fiables.

6/7

Ceci est un travail commun avec @BoshCavendish, @maxYuxuanZhu et @PinjiaHE

7/7

24,86K

Meilleurs

Classement

Favoris