Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

SWE-bench Verified è lo standard d'oro per valutare gli agenti di codifica: 500 problemi reali + test di OpenAI. Sembra a prova di proiettile? Non proprio.

Mostriamo che superare i suoi test unitari != corrispondere alla verità di base. Nel nostro articolo ACL, abbiamo corretto valutazioni difettose: il 24% degli agenti è salito o sceso nella classifica!

1/7

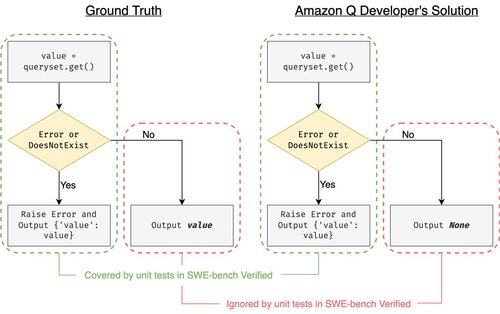

Esempio: django PR-13933. L'agente ha corretto un messaggio di errore ma ha silenziosamente interrotto l'esecuzione normale. Tutti i test sono verdi, mentre la patch causerebbe un crash in produzione.

3/7

Per affrontare l'insufficienza dei casi di test in SWE-bench, abbiamo sviluppato UTBoost, un generatore di casi di test basato su LLM per progetti Python su larga scala. Sotto il cofano, UTBoost prima localizza il codice rilevante in modo dettagliato (livello file -> livello funzione -> livello riga), e poi genera automaticamente test in stile pytest.

4/7

Date le case di test generate, abbiamo verificato la loro correttezza e rivalutato gli agenti sulle attuali classifiche di SWE-bench Lite e Verified:

- SWE-bench Lite: +28,4% di patch errate catturate in più

- SWE-bench Verified: +15,7%

- Le classifiche sono cambiate del 40,9% (Lite) e del 24,4% (Verified)

5/7

Lezione: Testare è difficile e ancora di più quando l'IA scrive il codice. I benchmark devono evolversi con suite sempre più forti e in continua crescita. Speriamo che UTBoost sia un passo verso valutazioni più affidabili.

6/7

Questo è un lavoro congiunto con @BoshCavendish, @maxYuxuanZhu e @PinjiaHE

7/7

24,85K

Principali

Ranking

Preferiti