Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

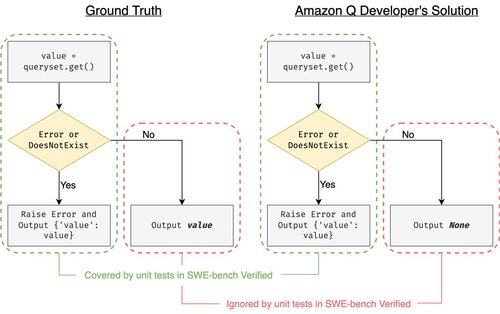

SWE-bench Verified er gullstandarden for evaluering av kodeagenter: 500 virkelige problemer + tester av OpenAI. Høres skuddsikkert ut? Bortimot.

Vi viser å bestå enhetstestene != samsvarende grunnsannhet. I ACL-artikkelen vår fikset vi buggy-vurderinger: 24 % av agentene flyttet opp eller ned på ledertavlen!

1/7

Eksempel: django PR-13933. Agenten fikset en feilmelding, men brøt stille normal utførelse. Alle tester er grønne, mens oppdateringen ville krasje i produksjonen.

3/7

For å løse de utilstrekkelige testtilfellene i SWE-bench, utviklet vi UTBoost, en LLM-basert testcasegenerator for fullskala Python-prosjekter. Under panseret lokaliserer UTboost først relevant kode på en finkornet måte (filnivå -> funksjonsnivå -> linjenivå), og genererer deretter automatisk tester i pytest-stil.

4/7

Gitt de genererte testtilfellene, verifiserte vi deres riktighet og revurderte agentene på de nåværende ledertavlene til SWE-bench Lite og Verified:

- SWE-benk Lite: +28,4% flere feilflekker fanget

- SWE-benk Verifisert: +15,7 %

- Rangeringer endret 40,9 % (Lite) og 24,4 % (Verifisert)

5/7

Leksjon: Testing er vanskelig og enda vanskeligere når AI skriver koden. Benchmarks må utvikle seg med sterkere, stadig voksende suiter. Vi håper UTBoost er et skritt mot mer pålitelige evalueringer.

6/7

Dette er felles arbeid med @BoshCavendish, @maxYuxuanZhu og @PinjiaHE

7/7

24,84K

Topp

Rangering

Favoritter