Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

SWE-bench Verified je zlatý standard pro hodnocení kódovacích agentů: 500 problémů z reálného světa + testy od OpenAI. Zní to neprůstřelně? Skoro.

Ukážeme, že prošel jeho jednotkovými testy != odpovídající základní pravdivost. V našem dokumentu ACL jsme opravili chybné evaly: 24 % agentů se posunulo nahoru nebo dolů v žebříčku!

1/7

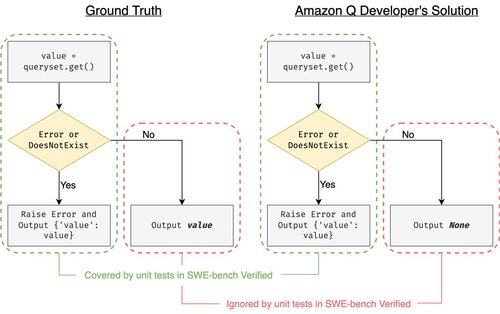

Příklad: django PR-13933. Agent opravil chybovou zprávu, ale tiše přerušil normální provádění. Všechny testy jsou zelené, zatímco oprava by v produkčním prostředí selhala.

3/7

Abychom vyřešili nedostatečné testovací případy v SWE-bench, vyvinuli jsme UTBoost, generátor testovacích případů založený na LLM pro plnohodnotné projekty Pythonu. Pod kapotou UTboost nejprve lokalizuje relevantní kód jemně odstupňovaným způsobem (úroveň souboru -> úroveň funkce -> úroveň řádku) a poté automaticky generuje testy ve stylu pytest.

4/7

Vzhledem k vygenerovaným testovacím případům jsme ověřili jejich správnost a přehodnotili agenty na aktuálních žebříčcích SWE-bench Lite a ověřili:

- SWE-bench Lite: +28,4 % více zachycených chybných záplat

- Ověřeno SWE-bench: +15,7 %

- Hodnosti změněny o 40,9 % (Lite) a 24,4 % (ověřeno)

5/7

Poučení: Testování je těžké a ještě těžší, když kód píše AI. Benchmarky se musí vyvíjet se silnějšími a stále se rozrůstajícími sadami. Doufáme, že UTBoost je jedním z kroků ke spolehlivějším hodnocením.

6/7

Jedná se o společnou práci s @BoshCavendish, @maxYuxuanZhu a @PinjiaHE

7/7

24,84K

Top

Hodnocení

Oblíbené