المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

إذن هذا سؤال:

كنت أفكر في بنية اللغة الإنجليزية وكيف يمكن أن تؤثر على تعلم التضمينات الموضعية.

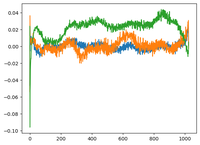

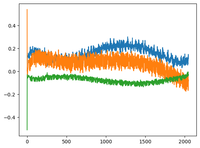

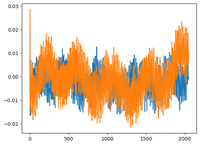

عدت إلى فيديو GPT2 الخاص ب @karpathy ورسم مصفوفة WPE ل GPT2 حيث تكون المؤامرة هي في الأساس قيم 3 قنوات محددة (من أصل 768 بعدا) كدالة للموضع (1024 ، حجم السياق).

قال إن pos_embeddings المتعلمين لديهم هيكل فيها. شعرت بالفضول ورسمت نفس الشيء لطرازين مفتوحي المصدر: EleutherAI / gpt-neo-125M ، و facebook / opt-125m ، وحصلت على نفس النتيجة (على ما أعتقد؟).

في ورقة المحولات الأصلية ، استخدم المؤلفون وظيفة جيبية ثابتة للتضمينات الموضعية. لماذا تتعلم النماذج البنية الجيبية باللغة الطبيعية؟

هل لأن اللغة الإنجليزية لها بنية جيبية؟ عادة ما تسبق الموضوعات الأفعال ، والجمل لها ترتيب زمني أو سببي ، وما إلى ذلك؟

91.77K

الأفضل

المُتصدِّرة

التطبيقات المفضلة