Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

dus hier is een vraag:

ik dacht na over de structuur van het Engels en hoe dit de leer van positionele embeddings zou kunnen beïnvloeden.

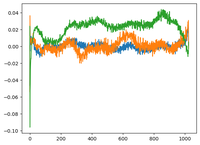

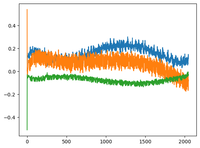

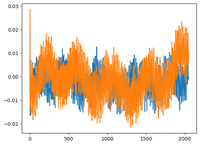

ik ging terug naar @karpathy's GPT2-video en hij plotte de wpe-matrix voor GPT2, waar de plot in wezen de waarden van 3 specifieke kanalen (uit de 768 dimensies) als functie van de positie (1024, contextgrootte) is.

hij zei dat de geleerde pos_embeddings een structuur in zich hebben. ik werd nieuwsgierig en plotte hetzelfde voor 2 andere open-source modellen: EleutherAI/gpt-neo-125M en facebook/opt-125m, en ik kreeg hetzelfde resultaat (denk ik?).

in het originele transformers-paper gebruikten de auteurs een vaste sinusfunctie voor positionele embeddings. waarom is het zo dat de modellen een sinusstructuur in natuurlijke taal leren?

is het omdat het Engels een sinusstructuur heeft? onderwerpen komen meestal vóór werkwoorden, clausules hebben een temporele of causale volgorde, enz.?

92,68K

Boven

Positie

Favorieten