Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Итак, вот вопрос:

Я думал о структуре английского языка и о том, как она может повлиять на изучение позиционных встраиваний.

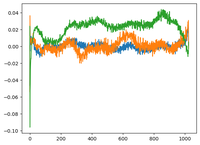

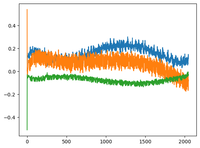

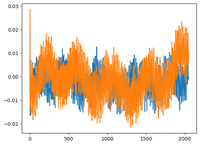

Я вернулся к видео @karpathy о GPT2, где он построил матрицу wpe для GPT2, где график в основном показывает значения 3 конкретных каналов (из 768 измерений) в зависимости от позиции (1024, размер контекста).

Он сказал, что изученные pos_embeddings имеют в себе структуру. Мне стало любопытно, и я построил то же самое для 2 других открытых моделей: EleutherAI/gpt-neo-125M и facebook/opt-125m, и я получил тот же результат (наверное?).

В оригинальной статье о трансформерах авторы использовали фиксированную синусоидальную функцию для позиционных встраиваний. Почему модели учат синусоидальную структуру в естественном языке?

Это потому, что английский язык имеет синусоидальную структуру? Субъекты обычно предшествуют глаголам, предложения имеют временной или причинный порядок и т.д.?

92,69K

Топ

Рейтинг

Избранное