Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Отже, ось питання:

Я думав про структуру англійської мови і про те, як вона може вплинути на вивчення позиційних вкладень.

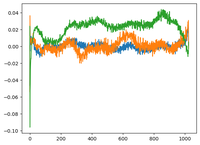

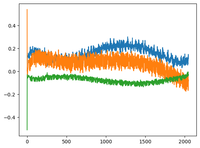

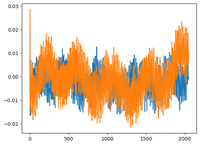

Я повернувся до відео @karpathy GPT2, і він побудував графік матриці WPE для GPT2, де графік в основному є значеннями 3 конкретних каналів (з 768 вимірів) як функція позиції (1024, розмір контексту).

Він говорив про те, що вчені pos_embeddings мають в собі структуру. Мені стало цікаво і я наніс те ж саме ще на 2 моделі з відкритим вихідним кодом: EleutherAI/gpt-neo-125M, і facebook/opt-125m, і отримав той самий результат (мабуть?).

У оригінальній роботі «Трансформатори» автори використовували фіксовану синусоїдальну функцію для позиційних вкладень. Чому моделі вивчають синусоїдальну структуру в природній мові?

Чи не тому, що англійська мова має синусоїдальну структуру? Підмети зазвичай передують дієсловам, речення мають часовий або причиновий порядок і т. д.?

93,01K

Найкращі

Рейтинг

Вибране