Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

więc mam pytanie:

myślałem o strukturze języka angielskiego i o tym, jak może to wpływać na naukę osadzeń pozycyjnych.

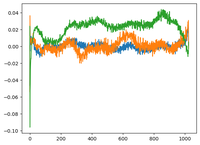

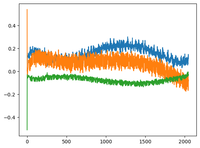

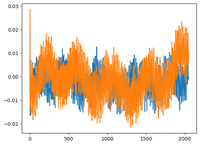

wróciłem do wideo @karpathy'ego o GPT2, gdzie wykreślił macierz wpe dla GPT2, w której wykres to w zasadzie wartości 3 konkretnych kanałów (z 768 wymiarów) w funkcji pozycji (1024, rozmiar kontekstu).

powiedział, że wyuczone osadzenia pozycyjne mają w sobie strukturę. Zaintrygowałem się i wykreśliłem to samo dla 2 innych modeli open-source: EleutherAI/gpt-neo-125M oraz facebook/opt-125m, i uzyskałem ten sam wynik (chyba?).

w oryginalnym artykule o transformatorach autorzy użyli stałej funkcji sinusoidalnej dla osadzeń pozycyjnych. dlaczego modele uczą się sinusoidalnej struktury w języku naturalnym?

czy to dlatego, że angielski ma sinusoidalną strukturę? podmioty zazwyczaj poprzedzają czasowniki, zdania mają porządek czasowy lub przyczynowy, itd?

93,01K

Najlepsze

Ranking

Ulubione