Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

quindi ecco una domanda:

stavo pensando alla struttura dell'inglese e a come potrebbe influenzare l'apprendimento delle embedding posizionali.

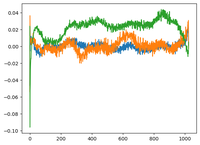

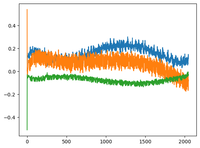

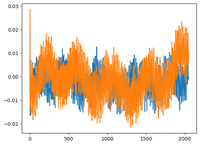

sono tornato al video di @karpathy su GPT2 e ha tracciato la matrice wpe per GPT2 dove il grafico è fondamentalmente i valori di 3 canali specifici (su 768 dimensioni) in funzione della posizione (1024, dimensione del contesto).

ha detto che le pos_embeddings apprese hanno una struttura in esse. sono diventato curioso e ho tracciato lo stesso per altri 2 modelli open-source: EleutherAI/gpt-neo-125M e facebook/opt-125m, e ho ottenuto lo stesso risultato (credo?).

nel documento originale sui transformers, gli autori hanno utilizzato una funzione sinusoidale fissa per le embedding posizionali. perché i modelli apprendono una struttura sinusoidale nel linguaggio naturale?

è perché l'inglese ha una struttura sinusoidale? i soggetti di solito precedono i verbi, le clausole hanno un ordine temporale o causale, ecc.?

92,68K

Principali

Ranking

Preferiti