Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Deci, iată o întrebare:

Mă gândeam la structura limbii engleze și la modul în care ar putea afecta învățarea încorporarilor poziționale.

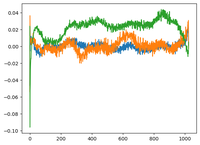

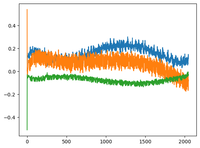

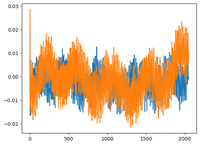

M-am întors la videoclipul GPT2 al lui @karpathy și a trasat matricea wpe pentru GPT2 unde graficul este practic valorile a 3 canale specifice (din cele 768 de dimensiuni) în funcție de poziție (1024, dimensiunea contextului).

El a spus că învățații pos_embeddings au o structură în ei. Am devenit curios și am trasat același lucru pentru încă 2 modele open-source: EleutherAI/gpt-neo-125M și facebook/opt-125m și am obținut același rezultat (cred?).

În lucrarea originală Transformers, autorii au folosit o funcție sinusoidală fixă pentru încorporarea pozițională. De ce modelele învață structura sinusoidală în limbaj natural?

Oare pentru că engleza are o structură sinusoidală? Subiecții preced de obicei verbele, propozițiile au ordine temporală sau cauzală etc.?

92,69K

Limită superioară

Clasament

Favorite