トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

そこで、ここに質問があります。

私は英語の構造と、それが位置埋め込みの学習にどのような影響を与えるかについて考えていました。

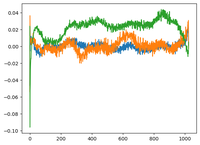

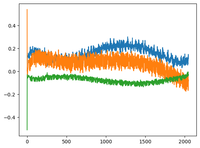

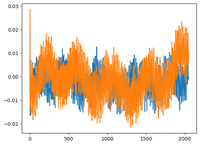

@karpathyのGPT2ビデオに戻り、彼はGPT2のwpe行列をプロットし、プロットは基本的に位置(1024、コンテキストサイズ)の関数として3つの特定のチャネル(768次元のうち)の値です。

彼は、学識のあるpos_embeddingsには構造があると言いました。私は興味を持って、さらに2つのオープンソースモデル(EleutherAI/gpt-neo-125Mとfacebook/opt-125M)について同じことをプロットし、同じ結果が得られました(おそらく?

元のTransformers論文では、著者らは位置埋め込みに固定正弦波関数を使用しました。なぜモデルは自然言語で正弦波構造を学習するのでしょうか?

英語は正弦波構造を持っているからでしょうか?主語は通常動詞の前にある、節には時間的または因果的な順序がありますか?

92.68K

トップ

ランキング

お気に入り