Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jadi inilah pertanyaannya:

Saya berpikir tentang struktur bahasa Inggris dan bagaimana hal itu dapat mempengaruhi pembelajaran penyematan posisi.

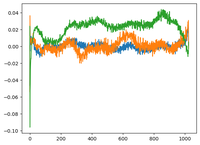

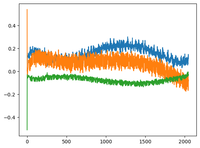

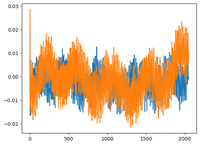

saya kembali ke video GPT2 @karpathy dan dia memplot matriks WPE untuk GPT2 di mana plotnya pada dasarnya adalah nilai dari 3 saluran tertentu (dari 768 dimensi) sebagai fungsi dari posisi (1024, ukuran konteks).

Dia mengatakan bahwa pos_embeddings terpelajar memiliki struktur di dalamnya. Saya penasaran dan merencanakan hal yang sama untuk 2 model open-source lagi: EleutherAI/gpt-neo-125M, dan facebook/opt-125m, dan saya mendapatkan hasil yang sama (saya kira?).

Dalam makalah Transformers asli, penulis menggunakan fungsi sinusoidal tetap untuk penyematan posisi. Mengapa model mempelajari struktur sinusoidal dalam bahasa alami?

Apakah karena bahasa Inggris memiliki struktur sinusoidal? subjek biasanya mendahului kata kerja, klausa memiliki urutan temporal atau kausal, dll.?

93,01K

Teratas

Peringkat

Favorit