Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Alors voici une question :

Je pensais à la structure de l'anglais et à la façon dont cela pourrait affecter l'apprentissage des embeddings positionnels.

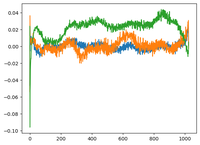

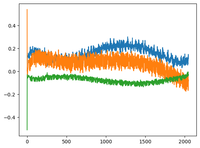

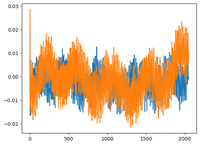

Je suis retourné à la vidéo GPT2 de @karpathy et il a tracé la matrice wpe pour GPT2 où le graphique représente essentiellement les valeurs de 3 canaux spécifiques (sur les 768 dimensions) en fonction de la position (1024, taille du contexte).

Il a dit que les pos_embeddings appris ont une structure en eux. Je suis devenu curieux et j'ai tracé la même chose pour 2 autres modèles open-source : EleutherAI/gpt-neo-125M et facebook/opt-125m, et j'ai obtenu le même résultat (je suppose ?).

Dans l'article original sur les transformers, les auteurs ont utilisé une fonction sinusoïdale fixe pour les embeddings positionnels. Pourquoi est-il vrai que les modèles apprennent une structure sinusoïdale dans le langage naturel ?

Est-ce parce que l'anglais a une structure sinusoïdale ? Les sujets précèdent généralement les verbes, les clauses ont un ordre temporel ou causal, etc. ?

93,01K

Meilleurs

Classement

Favoris