Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hier ist eine Frage:

Ich habe über die Struktur des Englischen nachgedacht und wie sie das Lernen von Positions-Embeddings beeinflussen könnte.

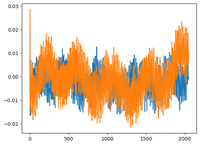

Ich habe mir @karpathy's GPT2-Video angesehen, in dem er die wpe-Matrix für GPT2 geplottet hat, wobei der Plot im Grunde die Werte von 3 spezifischen Kanälen (von insgesamt 768 Dimensionen) als Funktion der Position (1024, Kontextgröße) darstellt.

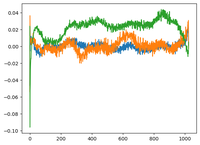

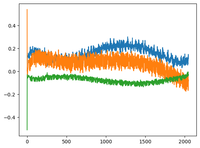

Er sagte, dass die gelernten pos_embeddings eine Struktur in sich haben. Ich wurde neugierig und habe dasselbe für 2 weitere Open-Source-Modelle geplottet: EleutherAI/gpt-neo-125M und facebook/opt-125m, und ich habe das gleiche Ergebnis erhalten (nehme ich an?).

Im ursprünglichen Transformers-Papier verwendeten die Autoren eine feste sinusförmige Funktion für Positions-Embeddings. Warum ist es so, dass die Modelle eine sinusförmige Struktur in natürlicher Sprache lernen?

Liegt es daran, dass Englisch eine sinusförmige Struktur hat? Subjekte stehen normalerweise vor Verben, Klauseln haben zeitliche oder kausale Reihenfolge usw.

92,68K

Top

Ranking

Favoriten