Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Så her er et spørsmål:

Jeg tenkte på strukturen til engelsk og hvordan det kan påvirke læringen av posisjonelle innbygginger.

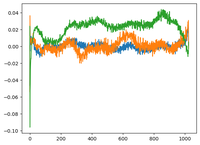

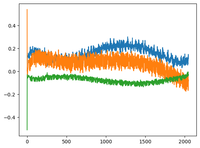

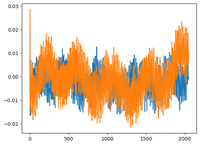

Jeg gikk tilbake til @karpathy GPT2-video, og han plottet wpe-matrisen for GPT2 der plottet i utgangspunktet er verdiene til 3 spesifikke kanaler (av de 768 dimensjonene) som en funksjon av posisjonen (1024, kontekststørrelse).

Han sa at de lærde pos_embeddings ha en struktur i seg. Jeg ble nysgjerrig og plottet det samme for 2 flere åpen kildekode-modeller: EleutherAI/gpt-neo-125M, og facebook/opt-125M, og jeg fikk det samme resultatet (antar jeg?).

I den originale Transformers-artikkelen brukte forfatterne en fast sinusformet funksjon for posisjonelle innbygginger. Hvorfor er det slik at modellene lærer sinusformet struktur i naturlig språk?

Er det fordi engelsk har en sinusformet struktur? subjekter kommer vanligvis foran verb, setninger har tids- eller kausal rekkefølge osv.?

93,01K

Topp

Rangering

Favoritter