Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

así que aquí hay una pregunta:

estaba pensando en la estructura del inglés y cómo podría afectar el aprendizaje de los embeddings posicionales.

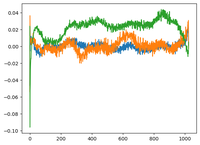

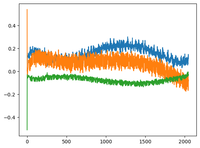

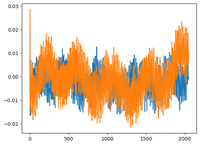

volví al video de GPT2 de @karpathy y él trazó la matriz wpe para GPT2 donde el gráfico es básicamente los valores de 3 canales específicos (de los 768 dimensiones) como una función de la posición (1024, tamaño del contexto).

dijo que los pos_embeddings aprendidos tienen una estructura en ellos. me dio curiosidad y tracé lo mismo para 2 modelos de código abierto más: EleutherAI/gpt-neo-125M y facebook/opt-125m, y obtuve el mismo resultado (supongo?).

en el artículo original de transformers, los autores utilizaron una función sinusoidal fija para los embeddings posicionales. ¿por qué es que los modelos aprenden una estructura sinusoidal en el lenguaje natural?

¿es porque el inglés tiene una estructura sinusoidal? los sujetos suelen preceder a los verbos, las cláusulas tienen un orden temporal o causal, etc.?

92,69K

Parte superior

Clasificación

Favoritos