Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Så här är en fråga:

Jag funderade på engelskans struktur och hur den kan påverka inlärningen av positionella inbäddningar.

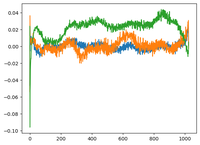

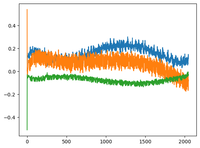

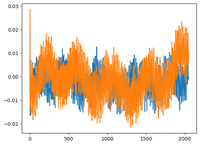

Jag gick tillbaka till @karpathy:s GPT2-video och han plottade wpe-matrisen för GPT2 där diagrammet i princip är värdena för 3 specifika kanaler (av de 768 dimensionerna) som en funktion av positionen (1024, kontextstorlek).

Han sa att de lärda pos_embeddings har en struktur i sig. Jag blev nyfiken och plottade samma sak för 2 mer öppen källkod modeller: EleutherAI / gpt-neo-125M, och Facebook / opt-125M, och jag fick samma resultat (antar jag?).

I den ursprungliga Transformers-artikeln använde författarna en fast sinusformad funktion för positionella inbäddningar. Hur kommer det sig att modellerna lär sig sinusformad struktur i naturligt språk?

Är det för att engelskan har en sinusformad struktur? Subjekt föregår vanligtvis verb, satser har tidsmässig eller kausal ordning, etc.?

92,69K

Topp

Rankning

Favoriter