热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

所以我有一个问题:

我在思考英语的结构,以及它可能如何影响位置嵌入的学习。

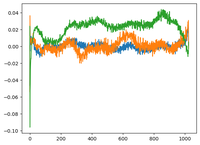

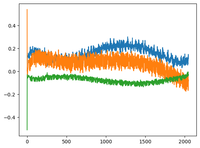

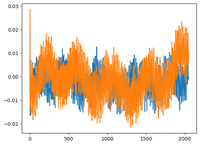

我回去看了@karpathy的GPT2视频,他绘制了GPT2的wpe矩阵,其中图表基本上是3个特定通道(在768个维度中)的值与位置(1024,上下文大小)的关系。

他说学习到的位置嵌入中有一种结构。我很好奇,于是对另外两个开源模型进行了相同的绘制:EleutherAI/gpt-neo-125M和facebook/opt-125m,结果是一样的(我想?)。

在原始的transformers论文中,作者使用了固定的正弦函数作为位置嵌入。为什么模型会在自然语言中学习到正弦结构?

这是否因为英语具有正弦结构?主语通常在动词之前,从句有时间或因果顺序,等等?

92.68K

热门

排行

收藏