Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Então aqui está uma pergunta:

Eu estava pensando sobre a estrutura do inglês e como isso pode afetar o aprendizado de incorporações posicionais.

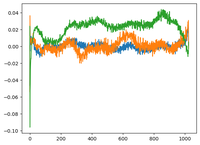

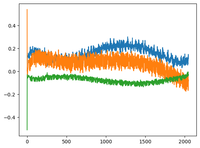

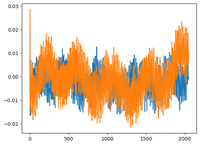

Voltei ao vídeo GPT2 de @karpathy e ele plotou a matriz wpe para GPT2, onde o gráfico é basicamente os valores de 3 canais específicos (das 768 dimensões) em função da posição (1024, tamanho do contexto).

Ele disse que os pos_embeddings eruditos têm uma estrutura neles. Fiquei curioso e planejei o mesmo para mais 2 modelos de código aberto: EleutherAI / gpt-neo-125M e facebook / opt-125m, e obtive o mesmo resultado (eu acho?).

No artigo original dos transformadores, os autores usaram uma função senoidal fixa para incorporações posicionais. Por que os modelos aprendem a estrutura senoidal em linguagem natural?

É porque o inglês tem uma estrutura senoidal? os sujeitos geralmente precedem os verbos, as orações têm ordem temporal ou causal, etc.?

92,68K

Melhores

Classificação

Favoritos