Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Takže tady je otázka:

Přemýšlel jsem o struktuře angličtiny a o tom, jak by mohla ovlivnit učení pozičních vnoření.

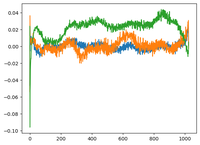

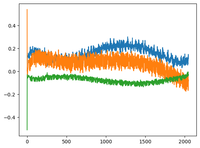

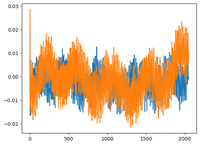

Vrátil jsem se k @karpathy videu GPT2 a on vykreslil WPE matici pro GPT2, kde graf jsou v podstatě hodnoty 3 konkrétních kanálů (ze 768 dimenzí) jako funkce polohy (1024, velikost kontextu).

Řekl, že učené pos_embeddings mají v sobě strukturu. Byl jsem zvědavý a vykreslil jsem to samé pro další 2 open-source modely: EleutherAI/gpt-neo-125M a facebook/opt-125m, a dostal jsem stejný výsledek (asi?).

V původním článku Transformers autoři použili pevnou sinusovou funkci pro poziční vnoření. Proč se modely učí sinusovou strukturu v přirozeném jazyce?

Je to proto, že angličtina má sinusovou strukturu? podměty obvykle předcházejí slovesům, věty mají časové nebo kauzální pořadí atd.?

93K

Top

Hodnocení

Oblíbené