Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Vậy đây là một câu hỏi:

Tôi đã suy nghĩ về cấu trúc của tiếng Anh và cách nó có thể ảnh hưởng đến việc học các nhúng vị trí.

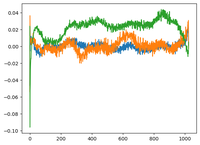

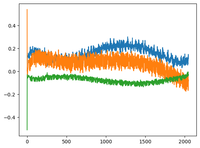

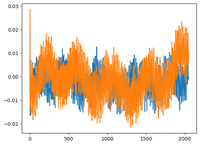

Tôi đã quay lại video GPT2 của @karpathy và anh ấy đã vẽ ma trận wpe cho GPT2, nơi biểu đồ chủ yếu là các giá trị của 3 kênh cụ thể (trong số 768 chiều) theo hàm của vị trí (1024, kích thước ngữ cảnh).

Anh ấy nói rằng các nhúng vị trí đã học có một cấu trúc trong đó. Tôi đã cảm thấy tò mò và vẽ cùng một điều cho 2 mô hình mã nguồn mở khác: EleutherAI/gpt-neo-125M và facebook/opt-125m, và tôi đã nhận được kết quả tương tự (tôi đoán vậy?).

Trong bài báo gốc về transformers, các tác giả đã sử dụng một hàm sin cố định cho các nhúng vị trí. Tại sao các mô hình lại học cấu trúc sin trong ngôn ngữ tự nhiên?

Có phải vì tiếng Anh có một cấu trúc sin không? Các chủ ngữ thường đứng trước động từ, các mệnh đề có thứ tự tạm thời hoặc nguyên nhân, v.v.?

92,68K

Hàng đầu

Thứ hạng

Yêu thích